基于多模态预训练模型的城市场景感知方法

原创 张喵喵 协同感知与知识服务 2022-09-06 09:28 发表于新加坡

收录于合集

#GIS15个

#数据4个

#大数据3个

#街景2个

ong //

Hi,大家好,今天给大家分享一篇最近被录用在International Journal of Applied Earth Observation and Geoinformation的一篇文章,这个期刊主要关注遥感,不过最近主编也逐渐增加了GIS相关文章的比例,大家有合适的工作可以考虑。

故事的起源是在几个月前看到了JAG众源数据的专刊, 正好手头有一个接近完成的工作,还有点纠结投哪里,就发邮件问了问。爱思唯尔的编辑和黄啸老师很热情,还给了投稿的链接,于是我就试试,编辑真的超级棒,我看送审前或审稿人返回意见后,每个文章状态只持续几个小时就会处理。这篇工作的idea是来自调研图文预训练模型,也就是最近炒得很火的多模态,我主要是复现VILBERT的工作,它实际上就是传统Bert的一个扩展,token不单单是单词,也兼容了图像块,之后又调研了基于COCO数据集训练的image caption模型,感觉效果还不错,并且我发现在街景领域做语义的为之甚少,大多都在做语义分割结果(绿视率,天空率,参见:基于多源传感器的城市人居环境与居民健康感知:中国武汉的案例研究)的相关分析,我就想能不能基于预训练模型,将图像转化成文本组织的描述,进而利用Bert文本模型进行微调。既然大规模预训练模型在计算机和遥感领域如火如荼(例如Resnet,VGG等视觉预训练模型都已经成为了遥感领域最基础的模块),那么在GIS领域文本预训练模型也应该有较强的适用性(如做地址识别,基于位置的社交媒体分析等等),本文也属于该方向的一个尝试。因为之前有Bert相关基础,这个实验没有花太多时间,张帆、陈能成老师也给了很多建议与指导,话不多说,直接上内容。

摘要

我们提出了一种基于大规模预训练模型的地理上可重复的城市场景感知方法。随着GeoAI研究的兴起,出现了许多高质量的城市观测数据集和深度学习模型。然而,地理空间的异质性使得这些资源在共享和迁移到新的应用场景方面具有挑战性。本文以街景图像分析为例,介绍了视觉语言和语义预训练模型。这架起了位置耦合下数据格式的桥梁,允许从人类的角度获取物理空间中的文本-图像城市场景的客观描述,包括实体、实体属性和实体之间的关系。此外,我们提出了SFT-BERT模型,从武汉8,923个场景中提取10个城市土地使用类别的文本特征集。结果显示,我们的方法优于七个基线模型,包括计算机视觉,与传统的深度学习方法相比,提高了15%,证明了预训练/微调范式在地理信息系统空间分析中的潜力。我们的模型也可以在其他城市重复使用,通过输入不同角度的街景图像,可以获得更准确的图像描述和场景判断。

代码下个推送开源,博主做一个街景跨模态解译的教程,欢迎大家关注!如有疏漏也欢迎指出!

引 言

以深度学习为代表的GeoAI方法在GIS领域取得了相当大的进展,特别是在街景图像分析和地理标签文本分析。然而,GeoAI研究也面临着空间-时间可复制性弱的紧迫问题。与物理、生物或计算机学科不同,城市研究中存在的空间依赖性和空间异质性导致了弱的地理可复制性。当改变研究区域时,尽管人们可以使用相同的数据来源和相同的分析方法,但不容易保证可以得到相同的结论。由于不同城市的建筑风格、社会经济、自然环境和风俗文化的差异,空间现象的发生和解释也可能发生变化。为了应对这样的挑战,许多学者致力于建立开源的地理数据库和开源的地理模型。

此外,现有研究的适用范围较小,用大量计算能力挖掘出来的地理空间知识难以共享,仅用少量人工标注的数据进行迁移学习的研究非常少。城市是人类活动的主要空间,随着传感器数量和种类的增加,海量的地理标记的多模态数据一直在产生。这些数据丰富了我们的城市感知手段,并可以相互验证。同时,大量的多模态数据也带来了许多挑战。

首先是 “数据瓶颈”。众所周知,深度学习是一种数据驱动的方法,模型往往包括大量的参数。准确可靠的大规模数据注释的成本很高,而少量的学习往往会出现欠拟合的问题。

其次是随着模型复杂性的增加而出现的 “计算能力瓶颈”。深度学习模型层数逐渐增加,模型的深度也逐渐上升。例如,GPT-3包括1750亿个参数。Swin transformer包括1.6万亿个参数,Bidirectional Encoder Representations from Transformers(Bert)的基础版本包括110M个参数,large版本包括340M个参数。显然,这么大的模型需要大幅提高计算能力,而普通用户很难承担这么高的训练成本。

第三,是 “模型瓶颈”。我们知道,在GeoAI领域有相当多的街景 “下游任务”,比如城市街景情感感知,城市形态,房价预测, 人类认知偏差, 土地利用分类, 环境与健康模型等。虽然有相当多的深度学习模型的开源代码,但仍然缺乏相对通用的模型,难以推广到其他GIS任务。面对新的地理问题,需要很多资源来重新获取数据,对其进行注释,建立模型,并训练它们。同时,城市数据的多源性、高度分散性和异质性使得它们很难被处理、融合和分析。迫切需要强大的多模态模型来弥合不同模态数据之间的界限。

为了解决上述三个瓶颈问题,我们引入了大规模视觉语言预训练(图像标题)模型和语义表示(Bert)模型。我们的方法有两个主要优点。首先,它可以提高GIS模型的可复制性,实际上是对城市景观的高度语义压缩。它可以将街景的环境感知扩展为场景的图像-文本感知。第二,实现一定程度的资源共享。使用预先训练的视觉语言模型可以减少计算成本和碳足迹,允许最先进的(SOTA)模型,而不需要从头开始训练它们。

据我们所知,这是大规模视觉语言预训练模型在街道图像的空间分析中的首次应用。它弥补了地理标签文本和街景图像之间的数据差距。换句话说,它可以客观地将城市物理空间翻译成人类语言。这可以避免地理文本数据中的主观描述和地理图像中的建筑风格所带来的城市间差异。

更重要的是,我们发现为特定的地理任务(本文的下游任务是基于街景图像的城市场景分类)微调(通过构建适当的损失函数)相关的、合适的预训练模型,可以用较少的计算能力成本和标记数据实现SOTA的结果。

本文的其余部分组织如下。

第二节比较了现有的预训练模型和街景图像分析的研究,引出了我们的工作。第三节介绍了视觉语言预训练(图像标题)模型,语义表示模型Bert,以及我们的微调模型SFT-BERT。第四节是我们的实验部分,在这里我们对城市街景进行推理,并获得场景的人类语言表征,在此基础上我们分别进行无监督和有监督的分析。SFT-BERT模型可以轻松实现SOTA的结果。文章最后在第5节给出了结论和展望。

相关工作

预训练模型是在公开的大规模数据集上训练出来的模型,由其他人创建,但可以用来解决类似问题。用户可以使用相关的训练过的模型作为基于知识的再学习的起点,而不是从头开始建立模型并专注于冷启动。凭借强大的泛化能力,大规模预训练模型在自然语言处理(NLP)和多模态领域取得了重大进展。

大量开源的预训练技术和模型已经出现,如VilBERT和UNIMO,用于处理数十种任务,如视觉问题回答,Word2vec和Glove用于学习单词共现概率的浅层语义特征。ELMo和GPT与词嵌入的上下文语义表示,极大地促进了相关领域的发展。

预训练模型比较常见的应用是在图像处理方面,如遥感。那些视觉预训练模型VGG、Inceptionv3、ResNet50、EfficientNet等都是在开源数据集上训练出来的,获得了多达数千个标签的分类能力。这些模型在土地利用分类和遥感图像中的元素物体识别等场景中自然具有很高的准确率。与遥感图像的常规格式不同,GIS数据的格式更为复杂,多为文本和图形形式。目前GIS领域的预训练模型的研究大多集中在直接调用编码器的固定表示,应用于土地利用类型分类(Word2vec),城市功能识别(Glove),社交媒体文本编码(Bert),洪水地址提取(Bert),短文结构识别(Bert)和其他领域。很少有研究注意到GIS中的多模态预训练模型及其强大的Few-Shot学习能力。事实上,预训练和微调的架构可以应用于大多数GIS任务,如推文情感分析、街景情感分类、地址文本识别和智能知识Q&A。与预训练相比,微调只需要少量的计算资源和较少的数据就可以达到满意的效果。此外,相关的合适的预训练模型是可重复使用的。本文以城市街景为例,分析基于这一范式。

事实证明,街景数据在城市传感领域具有良好的应用潜力,包含大量与人类相关的细粒度信息。其应用包括城市污染监测、碳排放估算、人类行为模式分析、街道信息提取、人口构成识别、场景感知等等。

然而,上述现有的工作大多只关注城市街道场景与研究区域内环境变量之间的关联。无论是街景的语义分割还是客观检测都无法从人类语言的角度描述城市环境。这就迫切需要新的GIS方法,不仅要抓住城市实体之间的空间关系,还要抓住实体的关键属性,并将其逻辑地组织在一个整体场景中。为了测试预训练的模型是否能在GIS中有效使用较少的注释数据,我们提出了基于不同场景文本描述的异质性的SFT-BERT方法。与直接使用卷积神经网络对街道场景进行图像分类相比,我们提取了人类自然描述特征。它可以获得 “场景感”,更接近于人类的主观感觉。

研究方法

如图1所示,我们将这项研究分为四个主要步骤。第一步,我们基于预先训练好的视觉语言模型对街景场景描述进行推理。它可以对街景图像进行高度的语义压缩,以获得地理标记的文本。在第二步中,一个取样地点会包含一些不同角度的图像。我们对它们进行汇总,并使用Bert来获得初始化的整体场景嵌入。在第三步,根据基本城市土地使用类别(EULUC,中国土地利用类型(城市功能)数据集)数据集对场景进行标注。在最后一步,我们 “冻结 “Bert模型的深层参数,添加一个分类层,并用浅层参数对其进行训练。我们使用微调后的 “SFT-Bert “模型来预测城市场景,并与其他六个基线进行比较评估。

图 1

街景语义描述的视觉语言模型(image-caption)

图像标题是为图像生成文本描述的过程,可以在图像模态和文本模式之间建立起一座桥梁。我们需要同时处理文本和图像,这可以被认为是一项将图像的像素序列转化为文本的字序列的任务。一个常见的图像标题模型架构如图2所示,分为两部分:编码器(绿色)和解码器(红色)。对于解码器部分,最常见的是长短期记忆(LSTM)递归神经网络。对于编码器部分(绿色),有三种主要方法。Resnet101特征,Bottom-Up特征,以及vilbert特征。这三种编码方法的主要区别是:Resnet101是一个101层的深度卷积神经网络,在100多万张图像上训练,可以识别1000个物体类别。Bottom-Up方法使用Faster R-CNN来提取图像特征,将图像分成k个区域。Vilbert则是一个图像和自然语言的联合表示预训练模型来提取特征。

多模态数据的注释是非常昂贵的,最有名的开源图像标题数据集有以下几个。

\1. 微软COCO数据集(它是最常用的多模态的训练资源,包括室内和室外环境,有超过150万个描述,超过33万张图片)。

\2. Flickr30k数据集(它包含从Flickr平台收集的31,000张图片,以及由人类志愿者提供的5个参考句子,这些句子主要来自社交媒体)。

\3. 谷歌概念说明数据集(300万张图片,与自然语言说明配对,主要来自互联网HTML页面)。

微软的Common Objects in Context数据集是最广泛适用的,也是我们使用的数据集。这个数据集包括室内和室外场景,80个物体类别,以及每张图片的5个人工注释的描述。微软公司邀请志愿者提供每张图片的文字描述,并对其进行交叉验证。

图 2

在image-cpation模型的训练过程中,我们同时输入图像(尺寸=800×500×3)和相应的描述(token number=N)。我们将在描述前后添加两个占位符[start]和[end],分别表示开始和结束。当解码器模块在第t步输出[end]时,它将表示循环的结束。该模型输入词嵌入序列(x1, x2, …, xN ),计算隐藏序列(h1, h2, …, hN ),并获得输出序列(y1, y2, …, yN )。

在模型达到收敛后,我们可以保存参数,预训练模型供下游任务使用。图像标题模型的主要质量评估指标是CIDEr score和SPICE score。在这项研究中,我们使用参考文献提供的预训练模型(CIDEr=1.158 SPICE=0.2114)从街景(地理标签图像)中计算出场景描述(地理标签文本)。

Bert语义预训练模型结构

Bert预训练模型在之前的推送介绍过一二, Bert是自然语言处理(NLP)领域的一个基于Transformer神经网络的语言模型,由Google在2018年首次提出;Bert及其结构变体在智能问答、语义检索、情感分类等11个NLP任务中刷新了最佳精度,是NLP领域最先进的模型之一。在本文中,我们使用Bert的基础版本,它由12个Transformer层、12个注意头、768个维度和110M个参数组成。预训练是一个在大规模语料库(如维基)上的无监督学习过程,模型有三个输入层。第一层是词嵌入层,它将文本映射到数学空间。第二层是段嵌入,在输入模型中标记不同的句子。而第三层是位置嵌入。与传统的序列模型不同,Bert使用的Transformer可以对数据进行并行计算,而position层的加入则有效地保留了单词之间的位置关系。除了词之外,[CLS]和[MASK]也在模型的预训练中被加入。其中[CLS]作为一个在起始位置没有特殊语义信息的符号,在训练过程中,可以更 “公平 “地整合文本中所有词的语义信息,使其成为提取句子特征的有效途径。

图 3

如图3所示,Bert在大规模文本数据(维基百科)上的自我监督训练是基于屏蔽语言模型(MLM)和下句预测(NSP)任务。MLM任务随机掩盖15%的文本输入,并使用周围的词来预测被屏蔽的词[MASK]。NSP任务是输入句子EB和从语料库中随机选择的句子E Random,让模型学习哪一个是EA的后续句子(段嵌入,图3a)。MLM教BERT理解单词之间的关系。NSP教BERT理解跨句子的长期依赖关系。预先训练一个大型模型是非常昂贵的,需要大量的图形处理单元(GPU)计算资源。相反,我们可以根据我们需要实现的城市场景分类的下游任务来 “微调 “预训练的模型。”微调 “是指将Bert网络作为新数据集的特征提取器,保持模型初始层的权重不变,只重新训练浅层参数。这样做的好处是在不需要太多计算能力的情况下达到SOTA的效果,而且在很少的图片数据集上也表现良好。

用场景感知损失函数对Bert模型进行微调(SFT-BERT)

预训练&微调范式是指通过预训练学习与下游任务不直接相关的一般语言特征,通过微调学习适用于特定任务的特征。一般来说,在神经网络中,底层和中层通常代表通用特征,而最后几层代表特定特征。Bert-Base的预训练模型包含12个转换层和1.1亿个参数,当冻结前8层(即只调整最后4层)时,下游任务的准确性并没有明显降低。换句话说,我们 “冻结 “Bert模型的大部分参数,并根据具体任务,通过增加新的功能层和辅助损失函数来更新剩余的参数(图3b)。而且它可以用比预训练低得多的计算能力达到最先进的(SOTA)结果。微调和预训练的区别在于,在最后一个变换器编码器之后增加了新的功能层,其次,文本不再是随机的 “屏蔽”,如图3所示。我们需要解决的下游任务是城市场景分类。我们将sigmoid分类器作为一个功能层加入,在Bert最后一个transformer层之后。它独立计算K类标签,并将K类损失加起来作为模型的总损失(迭代目标)。

不使用常见的softmax交叉熵损失函数的原因是,城市中的一些区域往往有多种功能。也就是说,这些地区同时具有多种场景的特征,不能准确地归入某一类。如果强迫那些特征不明显的地点预测相应的标签,反而会造成准确性的下降。损失函数的公式与进度评估公式在此不做介绍,详情可移步原文。

我们将场景感知的微调模型命名为SFT-BERT。参照之前介绍的中国城市功能产品(EULUC),本文将城市场景分为10类(K = 10)。如果该模型计算出的概率高于0.2,则将类作为预测的标签。

实验步骤

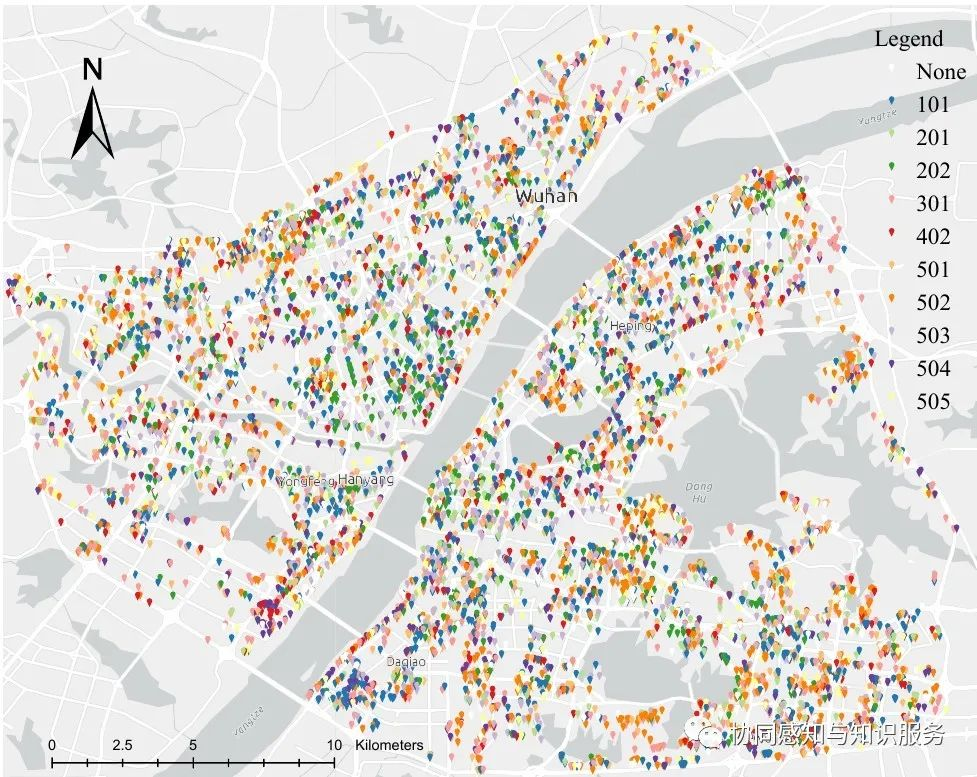

街景图像是一种带有地理标记的城市街道照片,具有可公开获得和容易获取的优势(地理标记数据(街景)介绍与分享)。它在GIS中被广泛用于城市的感知和定量分析。我们的研究区域在湖北省武汉市的三环路内,如图4所示。武汉三环路是一个具有典型城市物理环境特征的城区。我们从腾讯地图的18,907个采样点中获得了75,628张街景图片(800*500像素),每个地点有4张不同角度的街景照片。

图 4

表1列出了数据细节。透视经验一栏由两类数值组成,数值为2的是具有不确定性的机器采样视角,数值为4的是人工校准,对周围的兴趣点(POI)有更好的可见度。角度栏指的是采样视角与正北方向的水平角度,以度为单位,而图片标识是区域标识、方向和角度的组合。

获取城市场景的图文表达

我们把从不同角度对采样地点周围环境的感知定义为城市场景。城市往往会产生类似的街景图像,但不同角度的位置图像-文字描述共同构建了场景特征。它可以使实际场景得到更全面的复现。

我们使用前文中提到的视觉语言模型对武汉市75,628张街景图像进行了场景推理。该模型为每张图片生成文本,包括最相关的五句街道场景描述。在Tesla P100 GPU上,经过大约72小时的推理,总共产生了378140个城市的文本描述。来自四个不同角度的最佳相关描述被拼接在一起,以获得代表取样地点的城市场景的一般文本描述。我们在研究区域内随机选择了八个地点。然后,我们在图5中列出了街景图像和最佳相关图像说明。唯一的错误发生在图5G中,行人的影子被错误地识别为滑板,但这并不影响对场景的整体判断。

图 5

场景推理结果的优势不仅包括元素实体(这也可以用常见的实体检测框架如Mask CNN来实现),还包括实体之间的空间位置关系和属性。这可以提供比地理图像更直观的知识。由于本节的工作已经提取了人类最感兴趣的场景的关键元素,这样的特征工程也有助于快速部署场景识别算法。该数据集也可以重新用于相关的城市多模态研究,并已上传和共享。

用语义信息探索城市场景的独立性

为了提取城市场景的一些深层特征,使用Bert句子嵌入方法([CLS]为768维编码,图3b)对获得的18907个场景描述文本进行处理。我们提取所有场景的语义特征,并生成一个大小为18907×768的特征提取矩阵。然后使用HDBSCAN算法对这个矩阵进行无监督聚类,以发现城市中有多少个独立的场景。然后使用统一模态逼近和投影(UMAP)对场景语义进行缩减,其优点是尽可能多地保留全局结构,如图6所示。

图 6

插播小彩蛋,文章是在北京冬奥会期间撰写的,为了庆祝我使用了冬奥配色来绘制图6,张导在色彩搭配上可谓顶级的,色彩编码如下。

图6显示,场景可以更好地划分为12个类别,根据语义特征可以很好地将它们区分开来。换言之,城市场景具有明显的类别特征。为了揭示每个类别中具体包含的实体相关关系。我们使用Latent Dirichlet Allocation(LDA)主题模型来提取不同场景下的关键词。LDA是一个概率分布模型,不关心单词在文档中的位置。我们将所有的城市场景描述视为一个文档,并分析它们的依赖关系(话题)。主题的数量与HDBSCAN中的集群数量一致。我们从包含678个核心词的18,907个场景的语料库中计算了主题-词共同出现的频率矩阵,结果见:

主题挖掘的结果似乎与道路、行人、机动车等元素的场景组合有关。然而,我们在挖掘每一类场景所代表的物理意义方面却有困难。换句话说,这些无监督方法的识别结果,无论是场景嵌入的聚类还是主题模型,都不符合标准的城市功能分类标准,这需要新的监督分类算法。为了使我们的模型在其他城市可以直接复用,我们在下一节建立并训练了我们的微调模型,并辅以标准的城市功能分类标签。

获得场景标签并使用SFT-BERT模型进行预测

为了使我们的模型具有地理意义,我们使用了基于多个数据源的EULUC-China数据集,其中有12个不同的城市地块属性,由开放的街道地图数据进行分割。标签参考了中国土地利用现状分类标准(GB/T 21010-2017)。按代码排序,101:住宅类,201:商务办公类,202:商业服务类。301:工业类,401:道路类(我们不关心这个类型),402:交通站点类,403:机场设施类,501:行政类,502:教育类,503:医疗类,504:体育和文化类,505:公园和绿地类。

图 7

由于大多数街景图像都是由采集车辆拍摄的,所以位置往往是在城市道路上。城市道路的宽度通常不超过100米,所以我们设置了50米的缓冲距离来 “膨胀 “街景位置并获得城市场景的标签。在研究区域内,我们不关心道路类别,而机场设施类别的数量只有1,所以我们只保留了10个标签。

如图7所示,将不同视图的描述进行拼接,以表示该场景。一部分采样地点没有EULUC标签,经过清理,得到了8,923个有意义的场景地点。我们使用介绍的SFT-BERT模型,参数设置参考了Bert论文中的内容,BATCH_SIZE=32,LEARNING_RATE=2e-5,MAX_SEQ_LENGTH=128。训练集为90%,测试集为10%。预训练模型是Bert_base_uncased_L-12_H-768_A-12。实验中,使用TensorFlow 1.15深度学习框架。经过训练的模型可以计算出数据属于每个城市场景的概率。

我们将SFT-Bert与标准基线算法TextCNN、多层感知器(MLP)、K近邻(KNN)、支持向量机(SVM)、决策树(DT)、Naive Bayes分类器(Bayes)进行比较,在精度、F1、召回率、计算单元和模型训练时间方面进行比较。

我们对SFT-BERT进行了三个epoch的训练,并在7分21秒内取得了SOTA结果。与基线算法相比,模型的准确性提高了约15%。比较方法使用相同的参数设置,90%作为训练集,10%作为测试集。TextCNN作为一种非预训练的深度学习方法,不需要计算大量的预训练参数,在较少的训练时间内(在GPU上为18.6秒)达到了第二好的准确性。由于城市场景不像人类语言那样丰富,贝叶斯方法也是一个不错的选择,该模型在中央处理器(CPU)上的训练时间仅为0.1秒,取得了第三好的结果。我们还将其与计算机视觉方法进行了比较。同样地,我们将不同视角的街道图像 “拼接 “在一起,并使用残差神经网络(ResNet)来识别城市场景。由于没有视觉语言的预训练模型来进行图像的特征工程(预处理),所以花费了最多的计算时间而没有取得最好的结果。面对不平衡的数据标签和一些不同场景的高图像相似度,Resnet模型存在一些过拟合问题。相比之下,用人类注意力视角获得的场景描述具有更高的鲁棒性。

与直接使用图像相比,跨模态计算过程必然会造成信息的损失,但它也带来了一些好处,即提高了模型的概括性和可复制性。当直接使用视觉信息时,不同国家的建筑风格可能会对预测产生影响。使用高度语义压缩的图像表示(image caption),获得的城市实体和实体属性信息更有利于场景识别。

Few-shot学习和迁移实验来测试模型的准确性

为了验证SFT-Bert模型在Few-shot情况下的准确性,并平衡训练数据分布。我们为每个标签随机选择80个数据,共800个数据进行训练,占标签数据的10%左右。图9是预测结果,与图7将整体区域作为空间单位不同,我们更关注城市局部场景。我们的预测结果与实际场景的对比见图10。图10 A的预测结果与EULUC(图7)一致,都是商业服务类,有明显的特征。这类场景的特点是街道两旁有大量的商店,满是汽车和熙熙攘攘的人群。图10 B预测该场景为公园和绿地(504),图7预测该区域为教育类(502),从纯粹的视觉角度来看,很难区分哪一类是真的。这就需要增加语义信息,如POI来辅助判断。图10 C与EULUC一致,属于工业类(301)。最明显的特征是有大量的工业厂房。图10 D被预测为医疗类(503),这似乎是一个住宅区,该模型在识别这种没有明显视觉特征的场景(医疗类)时效果较差。

图 9

图 10

我们绘制了几张照片的学习结果的混淆矩阵(图11)。由于我们使用相同数量的标签进行训练,大量属于住宅类别的区域被归类为其他类别。EULUC产品代表了整体区域的功能(图8),而我们的预测是场景级别的,分辨率更高(图9)。然而,我们的模型不善于区分没有视觉差异的场景。而且它可以通过合并具有相似视觉特征的类别来减少数量。

图 11

最后,我们选择了新加坡和纽约进行迁移实验,以验证其地理上的可复制性。我们对各城市的谷歌街景数据进行了采样(纽约201个地点的804张图片和新加坡402个地点的1608张图片),预测结果如图12所示。预测标签为101、301、502、504的地点较多,这与武汉市的训练标签分布相似。虽然我们的模型是在武汉的腾讯街景中训练的,但在其他城市的谷歌街景图片中的实验也显示了高度的一致性。请注意,如果我们有新城市的土地功能标签(SG,NY),即使分类标准与中国的EULUC不一致,执行短时间的迁移学习也会优化结果。

我们的纯视觉方案的优点是可以忽略不同的建筑风格,即使迁移到其他城市也仍然适用。缺点是视觉方案不包含语义信息,没有明显的视觉特征就很难区分类别。

本节使用城市场景分类的下游任务作为一个例子,展示了大规模预训练模型在GIS相关分析中的潜力。其优点是用户不需要关注模型的预训练过程,具有广泛的应用场景。与几十个GPU长达数周的预训练过程相比,表3中显示的训练时间显然是可以接受的。GeoAI任务经常面临数据不足和启动效果不佳的问题,这导致在引入深度学习算法时需要大量的前期人工注释。大规模的预训练模型可以显著提高不同GIS任务(如城市犯罪风险分类、城市活力感知、城市建成区识别等与社会经济环境密切相关的任务)应用的有效性,并使模型更具通用性。由于STF-BERT是从一个大的语料库中学习的,可以很容易地避免基于少量数据的过拟合。

图 12

讨论与展望

本文引入了一个视觉语言模型来处理街景图像,它可以自动生成城市场景的文本解释。同时,利用语义表征模型构建了一个城市场景感知的损失函数。我们的研究发现,与TextCNN和MLP模型相比,预训练+微调的方法有其固有的优势,后者从头开始训练神经网络参数。而我们的模型大部分参数是固定的,模型已经学会了一定的特征描述能力,具有先天的知识红利,训练后的数据集越大,效果越明显。自从BERT预训练模型被提出并被定为2018年主要NLP任务的榜首后,深度学习的NLP算法已经逐渐过渡到使用大型预训练模型来微调下游的不同任务的模式。这种方法利用大型模型和大型开源预训练语料库,将模型理解自然语言的能力提高了一个档次。城市是人类活动的主要载体,一直在产生大量的自然语言信息。现有的GIS研究更多地集中在私人数据上,缺乏通用的基线算法和数据集,由于其信息容量小,很难普及。此外,我们还需要考虑空间的异质性。城市场景预测还需要考虑路网拓扑结构和区域相邻关系,这将是一个很好的优化方向,也是我们下一个工作的内容。

如果您觉得有帮助,请引用我们的文章:Yan Zhang and Fan Zhang and Nengcheng Chen. Migratable urban street scene sensing method based on vision language pre-trained model[J]. International Journal of Applied Earth Observation and Geoinformation.

排版:刘洁